Amvera LLM Inference¶

Общая доступность LLM планируется 15 июля 2025 г.

Мы предоставляем доступ к нескольким большим языковым моделям через единый публичный API.

Аутентификация¶

Чтобы использовать Amvera LLM Inference API, необходимо пройти аутентификацию:

Для этого в ЛК, нужно зайти в любую модель в разделе LLM, и скопировать токен доступа.

Затем, при обращении к моделе, укажите токен доступа в заголовке X-Auth-Token в следующем формате: [X-Auth-Token: Bearer <access_token>]

API¶

Доступные варианты инференса¶

/llama

llama8b— модель с 8 миллиардами параметров, оптимизированная для эффективной обработки текста.llama70b— модель с 70 миллиардами параметров, обеспечивающая более высокое качество генерации и обработки текста.

/gpt

gpt-4.1— модель gpt-4.1 от OpenAI.gpt-5— модель gpt-5 от OpenAI.

/deepseek

deepseek-R1— модель DeepSeek-R1-0528 семейства DeepSeek-AI.deepseek-V3— модель DeepSeek-V3-0324 семейства DeepSeek-AI.

/qwen

qwen3_30b— модель Qwen3-30B-A3B-Instruct-2507 семейства Qwen.qwen3_235b— модель Qwen3-235B-A22B-Instruct-2507 семейства Qwen.

Конечная точка модели¶

Для отправки запросов к моделям используйте следующий формат запроса к конечной точке: POST /models/<inference_name>. Например: POST /models/llama

Эта конечная точка позволяет отправлять запросы к выбранной модели. В зависимости от ваших нужд, в теле запроса нужно выбрать одну из доступных моделей (llama8b или llama70b).

Пример запроса/ответа:¶

Request:

{

"model": "llama8b",

"messages": [

{

"role": "user",

"text": "Hi, how are you?"

}

]

}

Интеграция с LangChain/LangGraph¶

Установите библиотеку для интеграции.

pip install langchain langchain-amvera

Код интеграции

from langchain_amvera import AmveraLLM

from dotenv import load_dotenv

import os

load_dotenv()

# Поддерживаемые модели: llama8b, llama70b, gpt-4.1, gpt-5

llm = AmveraLLM(model="llama70b", api_token=os.getenv("AMVERA_API_TOKEN"))

response = llm.invoke("Объясни принципы работы нейросетей простым языком")

print(response.content)

Файл .env:

AMVERA_API_TOKEN=your_amvera_token_here

Подробная информация про адаптер для LangChain/LangGraph по ссылке https://pypi.org/project/langchain-amvera/

Интеграция с n8n¶

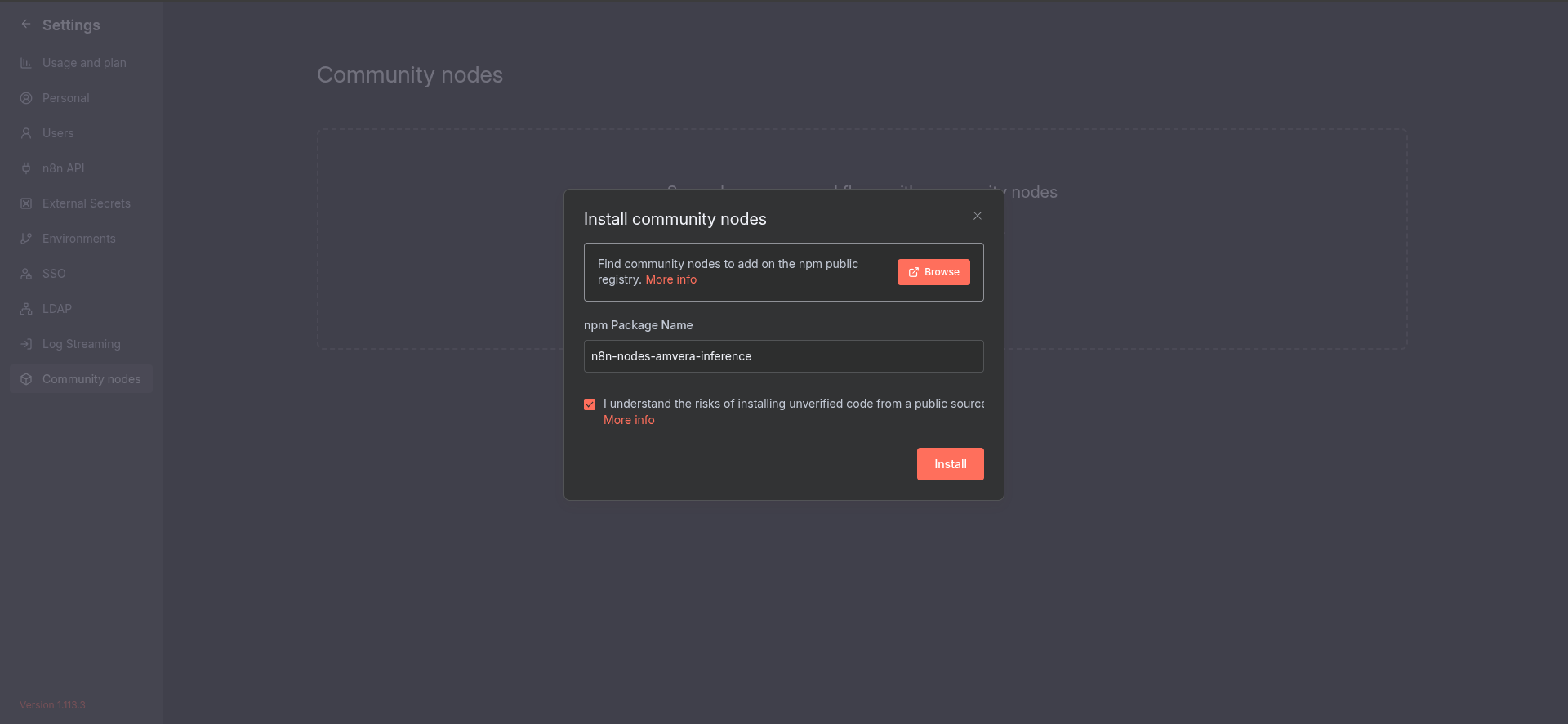

С 4 октября 2025 года Amvera LLM Inference API доступен как комьюнити-нода в n8n.

Для установки убедитесь, что ваша версия n8n поддерживает Community Nodes. Для этого перейдите в настройки n8n (Ваша аватарка -> Settings).

Если вы увидите вкладку Community Nodes - переходите в нее и устанавливаете ноду n8n-nodes-amvera-inference.

Если вкладки нет - попробуйте обновить версию n8n во вкладке «Конфигурация» и добавить переменную окружения

N8N_COMMUNITY_NODES_ENABLEDв значенииtrue

Установка комьюнити-ноды может занять до 10 минут. Если вы получаете ошибку, надо просто подождать. Повторной установкой вы можете прервать текущий процесс установки ноды.

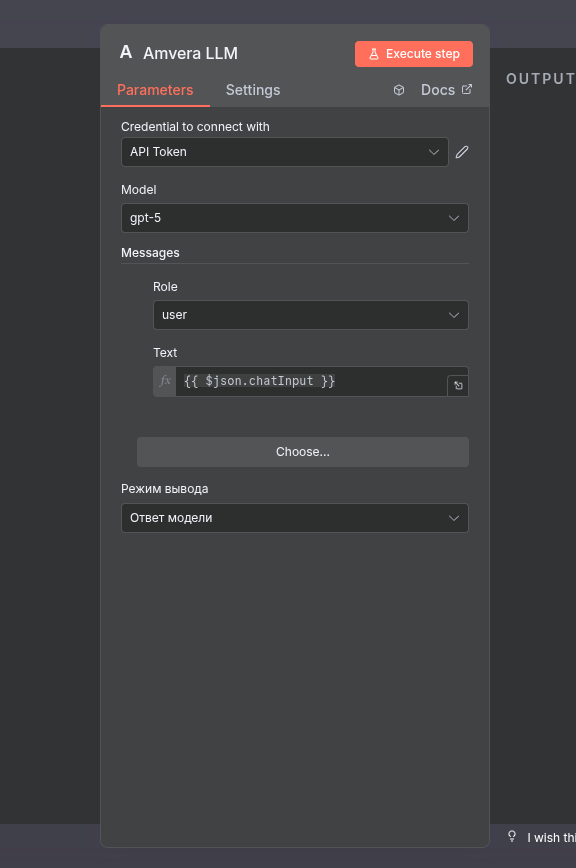

Базовые настройки ноды¶

Для работы с нодой необходимо создать Credentials в ее настройках и выбрать модель, создать минимум одно сообщения (system, user или assistant).

Режимы вывода¶

Всего поддерживается 2 режима вывода:

Ответ модели: выводится только ответ модели

JSON: выводится весь JSON Raw (весь ответ Amvera LLM Inference API)